Noyaux supplémentaires#

En plus des noyaux Python, sont disponibles sous Jupyterlab les noyaux suivants:

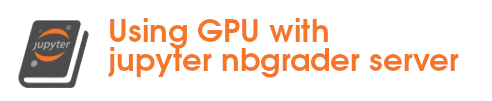

Noyau R avec des R-Notebook#

Un noyau R est installé sous Juputerlab pour permettre la programmation avec un noyau IRKernel[8].

Vous trouverez ci-dessous la liste des bibliotèques disponibles.

Liste des paquets R disponibles

Packages R disponibles

Packages dans la bibliothèque ‘/usr/local/lib/R/site-library’ :

askpass Password Entry Utilities for R, Git, and SSH

base64enc Tools for base64 encoding

brew Templating Framework for Report Generation

brio Basic R Input Output

bslib Custom 'Bootstrap' 'Sass' Themes for 'shiny'

and 'rmarkdown'

cachem Cache R Objects with Automatic Pruning

callr Call R from R

cli Helpers for Developing Command Line Interfaces

clipr Read and Write from the System Clipboard

colorspace A Toolbox for Manipulating and Assessing Colors

and Palettes

commonmark High Performance CommonMark and Github Markdown

Rendering in R

cpp11 A C++11 Interface for R's C Interface

crayon Colored Terminal Output

credentials Tools for Managing SSH and Git Credentials

crosstalk Inter-Widget Interactivity for HTML Widgets

curl A Modern and Flexible Web Client for R

data.table Extension of `data.frame`

DatastreamDSWS2R Provides a Link Between the 'LSEG Datastream'

System and R

desc Manipulate DESCRIPTION Files

devtools Tools to Make Developing R Packages Easier

diffobj Diffs for R Objects

digest Create Compact Hash Digests of R Objects

downlit Syntax Highlighting and Automatic Linking

dplyr A Grammar of Data Manipulation

eikonapir Refinitiv Eikon Scripting API for R

ellipsis Tools for Working with ...

evaluate Parsing and Evaluation Tools that Provide More

Details than the Default

fansi ANSI Control Sequence Aware String Functions

farver High Performance Colour Space Manipulation

fastmap Fast Data Structures

fontawesome Easily Work with 'Font Awesome' Icons

foreach Provides Foreach Looping Construct

fs Cross-Platform File System Operations Based on

'libuv'

generics Common S3 Generics not Provided by Base R

Methods Related to Model Fitting

gert Simple Git Client for R

ggplot2 Create Elegant Data Visualisations Using the

Grammar of Graphics

gh 'GitHub' 'API'

gitcreds Query 'git' Credentials from 'R'

glue Interpreted String Literals

gtable Arrange 'Grobs' in Tables

highr Syntax Highlighting for R Source Code

htmltools Tools for HTML

htmlwidgets HTML Widgets for R

httpuv HTTP and WebSocket Server Library

httr Tools for Working with URLs and HTTP

httr2 Perform HTTP Requests and Process the Responses

ini Read and Write '.ini' Files

IRdisplay 'Jupyter' Display Machinery

IRkernel Native R Kernel for the 'Jupyter Notebook'

isoband Generate Isolines and Isobands from Regularly

Spaced Elevation Grids

iterators Provides Iterator Construct

jquerylib Obtain 'jQuery' as an HTML Dependency Object

jsonlite A Simple and Robust JSON Parser and Generator

for R

knitr A General-Purpose Package for Dynamic Report

Generation in R

labeling Axis Labeling

later Utilities for Scheduling Functions to Execute

Later with Event Loops

lazyeval Lazy (Non-Standard) Evaluation

lifecycle Manage the Life Cycle of your Package Functions

magrittr A Forward-Pipe Operator for R

memoise 'Memoisation' of Functions

mime Map Filenames to MIME Types

miniUI Shiny UI Widgets for Small Screens

munsell Utilities for Using Munsell Colours

openssl Toolkit for Encryption, Signatures and

Certificates Based on OpenSSL

pbdZMQ Programming with Big Data -- Interface to

'ZeroMQ'

pillar Coloured Formatting for Columns

pkgbuild Find Tools Needed to Build R Packages

pkgconfig Private Configuration for 'R' Packages

pkgdown Make Static HTML Documentation for a Package

pkgload Simulate Package Installation and Attach

plotly Create Interactive Web Graphics via 'plotly.js'

praise Praise Users

prettyunits Pretty, Human Readable Formatting of Quantities

processx Execute and Control System Processes

profvis Interactive Visualizations for Profiling R Code

promises Abstractions for Promise-Based Asynchronous

Programming

ps List, Query, Manipulate System Processes

purrr Functional Programming Tools

R6 Encapsulated Classes with Reference Semantics

ragg Graphic Devices Based on AGG

rappdirs Application Directories: Determine Where to

Save Data, Caches, and Logs

rcmdcheck Run 'R CMD check' from 'R' and Capture Results

RColorBrewer ColorBrewer Palettes

Rcpp Seamless R and C++ Integration

remotes R Package Installation from Remote

Repositories, Including 'GitHub'

repr Serializable Representations

rlang Functions for Base Types and Core R and

'Tidyverse' Features

rmarkdown Dynamic Documents for R

roxygen2 In-Line Documentation for R

rprojroot Finding Files in Project Subdirectories

rstudioapi Safely Access the RStudio API

rversions Query 'R' Versions, Including 'r-release' and

'r-oldrel'

sass Syntactically Awesome Style Sheets ('Sass')

scales Scale Functions for Visualization

sessioninfo R Session Information

shiny Web Application Framework for R

sourcetools Tools for Reading, Tokenizing and Parsing R

Code

stringi Fast and Portable Character String Processing

Facilities

stringr Simple, Consistent Wrappers for Common String

Operations

sys Powerful and Reliable Tools for Running System

Commands in R

systemfonts System Native Font Finding

testthat Unit Testing for R

textshaping Bindings to the 'HarfBuzz' and 'Fribidi'

Libraries for Text Shaping

tibble Simple Data Frames

tidyr Tidy Messy Data

tidyselect Select from a Set of Strings

tinytex Helper Functions to Install and Maintain TeX

Live, and Compile LaTeX Documents

urlchecker Run CRAN URL Checks from Older R Versions

usethis Automate Package and Project Setup

utf8 Unicode Text Processing

uuid Tools for Generating and Handling of UUIDs

vctrs Vector Helpers

viridisLite Colorblind-Friendly Color Maps (Lite Version)

waldo Find Differences Between R Objects

whisker {{mustache}} for R, Logicless Templating

withr Run Code 'With' Temporarily Modified Global

State

xfun Supporting Functions for Packages Maintained by

'Yihui Xie'

xml2 Parse XML

xopen Open System Files, 'URLs', Anything

xtable Export Tables to LaTeX or HTML

xts eXtensible Time Series

yaml Methods to Convert R Data to YAML and Back

zip Cross-Platform 'zip' Compression

zoo S3 Infrastructure for Regular and Irregular

Time Series (Z's Ordered Observations)

Packages dans la bibliothèque ‘/usr/lib/R/library’ :

base The R Base Package

boot Bootstrap Functions (Originally by Angelo Canty

for S)

class Functions for Classification

cluster "Finding Groups in Data": Cluster Analysis

Extended Rousseeuw et al.

codetools Code Analysis Tools for R

compiler The R Compiler Package

datasets The R Datasets Package

foreign Read Data Stored by 'Minitab', 'S', 'SAS',

'SPSS', 'Stata', 'Systat', 'Weka', 'dBase', ...

graphics The R Graphics Package

grDevices The R Graphics Devices and Support for Colours

and Fonts

grid The Grid Graphics Package

KernSmooth Functions for Kernel Smoothing Supporting Wand

& Jones (1995)

lattice Trellis Graphics for R

MASS Support Functions and Datasets for Venables and

Ripley's MASS

Matrix Sparse and Dense Matrix Classes and Methods

methods Formal Methods and Classes

mgcv Mixed GAM Computation Vehicle with Automatic

Smoothness Estimation

nlme Linear and Nonlinear Mixed Effects Models

nnet Feed-Forward Neural Networks and Multinomial

Log-Linear Models

parallel Support for Parallel Computation in R

rpart Recursive Partitioning and Regression Trees

spatial Functions for Kriging and Point Pattern

Analysis

splines Regression Spline Functions and Classes

stats The R Stats Package

stats4 Statistical Functions using S4 Classes

survival Survival Analysis

tcltk Tcl/Tk Interface

tools Tools for Package Development

utils The R Utils Package

Un exemple de Notebbok R est donné ci-dessous:

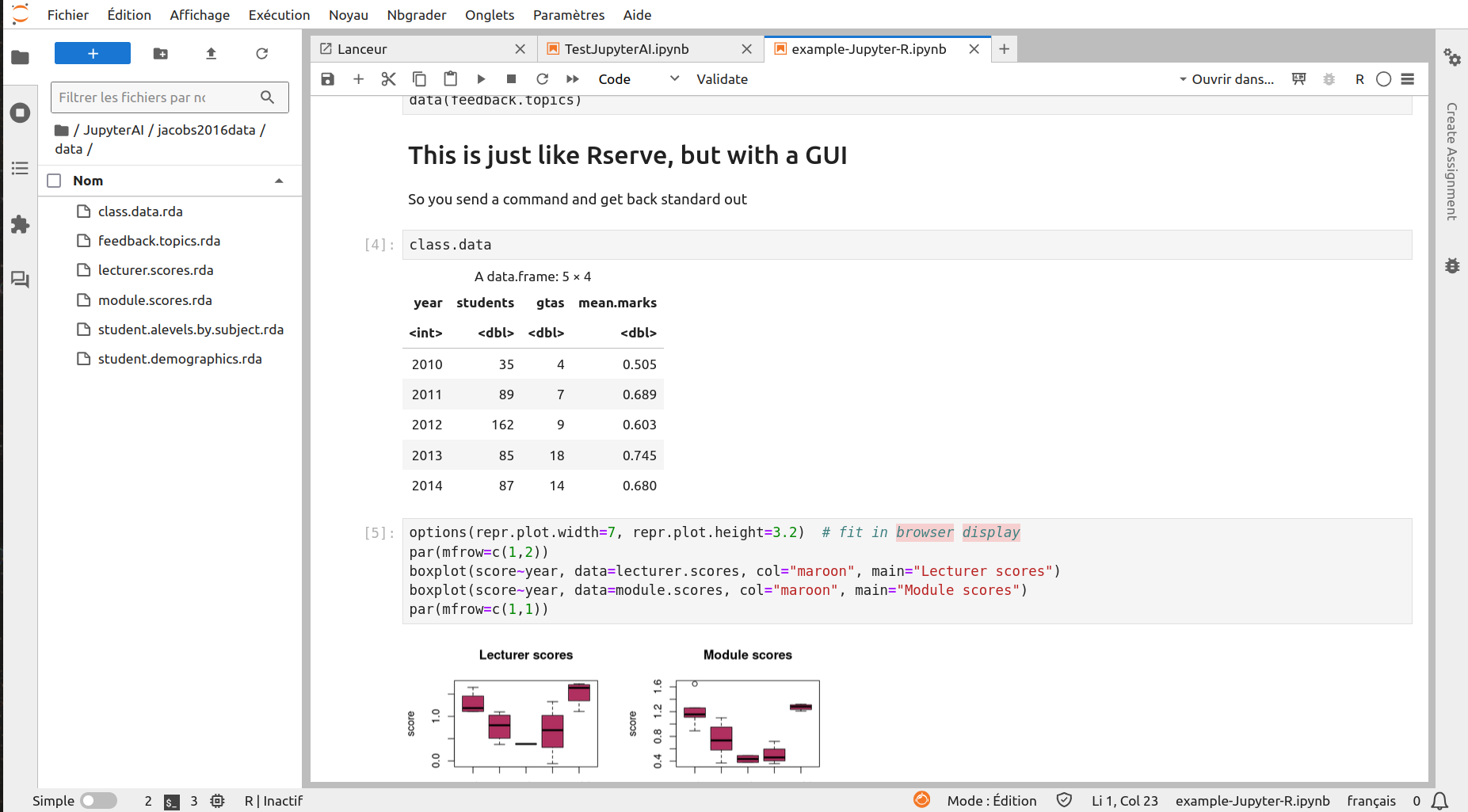

Noyau C++ (cling)#

Un noyau Jupyter C++ est aussi disponible, utilisant l’interpréteur C++ interactif cling[9].

Vous trouverez dans les sections suivantes un exemple d’utilisation de ce noyau

Pour l’ustilisation de cuda, les fichiers d’entêtes cuda sont dans /usr/local/cuda/include et les bibliothèques sont dans

/usr/local/cuda/lib64. Les outils cuda (nvcc, ..) sont dans /usr/local/cuda/bin

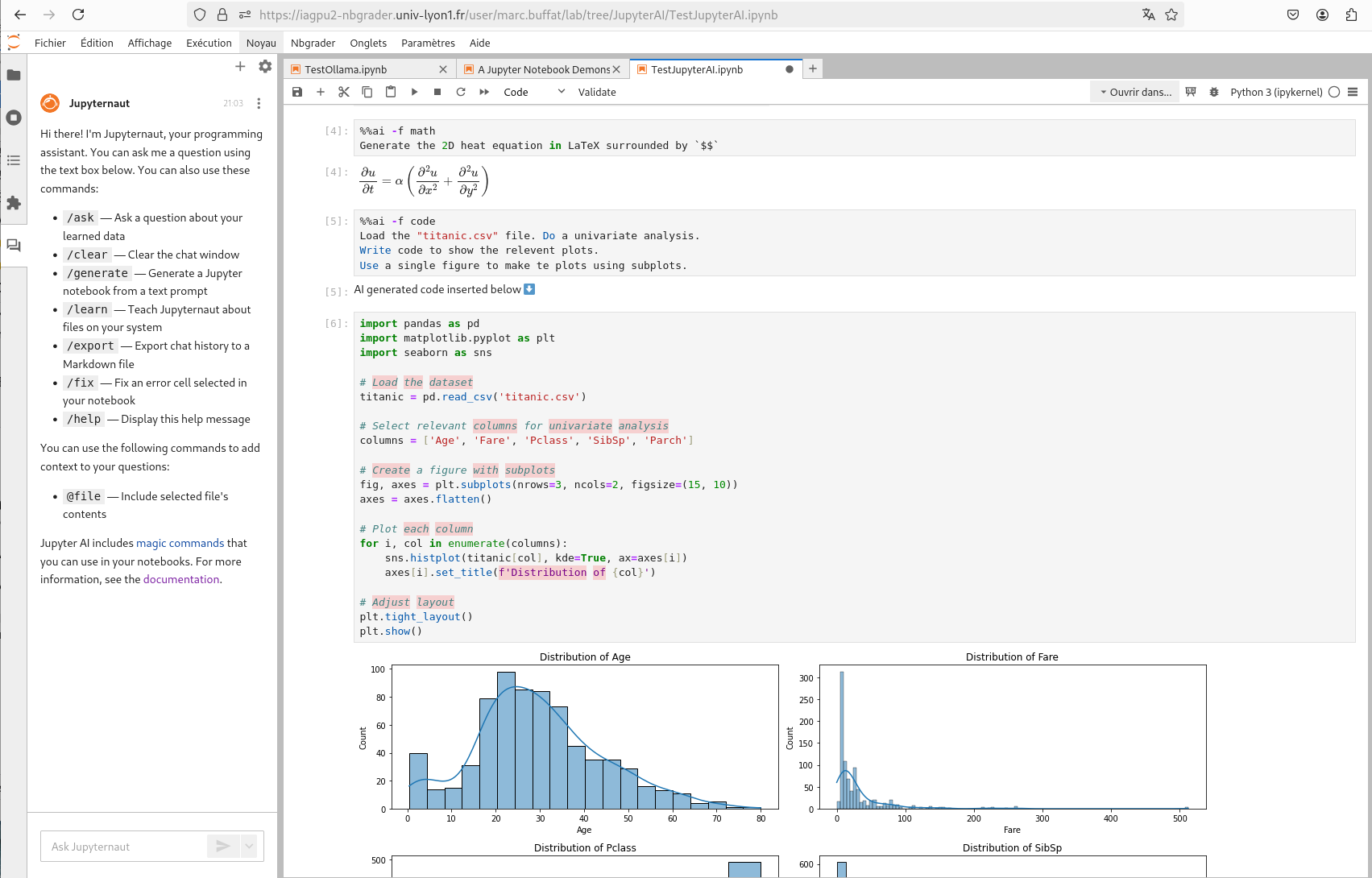

Jupyter AI#

Jupyter AI[6] est une extension de Jupyter qui permet d’utiliser des modèles AI génératives (LLM) dans des notebooks Ipython.

Attention pour utiliser cette extension, il faut avoir accès à un LLM (ChatGPT, Mistral, ..) et à son

API. On peut aussi utiliser Ollama[7], qui est installé sur le serveur, et qui permet

d’exécuter localement des modèles LLM comme ChatGPT, Mistral, LLama.

La liste actuelle des modèles est donnée par la commande ollama list:

ollama list

NAME ID SIZE MODIFIED

mistral-small:latest 8039dd90c113 14 GB 17 hours ago

deepseek-r1:70b 0c1615a8ca32 42 GB 46 hours ago

deepseek-r1:70b-llama-distill-fp16 5c3319143a79 141 GB 47 hours ago

llama3.2:latest a80c4f17acd5 2.0 GB 2 weeks ago

codellama:latest 8fdf8f752f6e 3.8 GB 2 weeks ago

La configuration sous JupyterAI avec Ollama est un peu délicate, et il est préférable

d’écrire directement le fichier de configuration config.json, qui se trouve dans

le répertoire de l’utilisateur: ~/.local/share/jupyter/jupyter_ai.

Le type fichier config.json pour ollama est de la forme

{

"model_provider_id": "ollama:codellama",

"embeddings_provider_id": "ollama:nomic-embed-text",

"send_with_shift_enter": true,

"fields": {},

"api_keys": {},

"completions_model_provider_id": null,

"completions_fields": {}

}

Une fois le modèle d’AI configuré, on peut interagir avec le modèle avec le chat JupyterAI à gauche de la fenêtre Jupyterlab.

Les principales commandes sont les suivantes:

/askpour poser une question/fixpour expliquer l’erreur dans la cellule sélectionnée/helppour l’aide/learnpour faire un apprentissage à partir de fichiers locaux dans un répertoire

On peut faire référence au contenu d’une cellule numéro num avec {In[num]} ou avec la sortie

correspondante avec Out[num]} ou l’erreur {Err[num]}.

On peut aussi interagir directement dans le Notebook en utilisant les commandes magiques %%ai et %ai

Au début du Notebook, on charge l’extension JupyterAI et on configure le modèle à utiliser

%load_ext jupyter_ai_magics

# p.e pour Mistral

%config AiMagics.default_language_model = "mistralai:mistral-large-latest"

%env MISTRAL_API_KEY=xxxxxxx

On peut ensuite interagir avec le mofèle LLM avec des commandes

%%ai

Vous trouverez dans la section suivante un exemple d’utilisation de JupyterAi dans un notebook IPython avec le LLM mistral.

et dans cette section la même application JupyterAI mais avec ollama. Le résultat pour la génération de code est un peu moins bon qu’avec mistral.