suivant: 8. Intégration numérique monter: 7. Meilleure approximation précédent: 7.1 Introduction Table des matières

Ce polynôme p(x) est appelée l'approximation au sens des moindres carrés discrets de f .

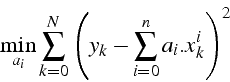

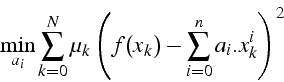

Soient N+1 points distincts ![]() , on veut déterminer les n+1 coefficients

, on veut déterminer les n+1 coefficients

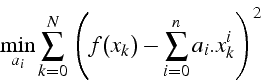

![]() minimisant l'erreur :

minimisant l'erreur :

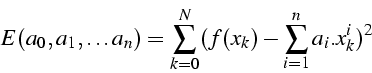

![]() est une forme quadratique en

est une forme quadratique en ![]() , et son minimum

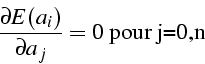

est atteint pour :

, et son minimum

est atteint pour :

On obtient un système linéaire d'ordre n+1 :

![\begin{displaymath}

A=\left[\begin{array}{cccc}

N+1 & \sum_{k=0}^{N}x_{k} & \ldo...

...{k}^{n+1} & \ldots & \sum_{k=0}^{N}x_{k}^{2n}\end{array}\right]\end{displaymath}](img413.png)

![\begin{displaymath}

B=\left[\begin{array}{c}

\sum_{k=0}^{N}y_{k}\\

\sum_{k=0}^{...

...{k}\\

\vdots\\

\sum_{k=0}^{N}x_{k}^{n}y_{k}\end{array}\right]\end{displaymath}](img414.png)

![\begin{displaymath}

X=\left[\begin{array}{c}

a_{0}\\

a_{1}\\

\vdots\\

a_{n}\end{array}\right]\end{displaymath}](img415.png)

Cette équation est ``l'équation normale''

Approximation

![]()

![]() ``équation normale''

``équation normale''

![\begin{displaymath}

A=\left[\begin{array}{cc}

N+1 & \sum_{k=0}^{N}x_{k}\\

\sum_{k=0}^{N}x_{k} & \sum_{k=0}^{N}x_{k}^{2}\end{array}\right]\end{displaymath}](img418.png)

![\begin{displaymath}

B=\left[\begin{array}{c}

\sum_{k=0}^{N}y_{k}\\

\sum_{k=0}^{N}x_{k}y_{k}\end{array}\right]\end{displaymath}](img419.png)

![\begin{displaymath}

X=\left[\begin{array}{c}

a_{0}\\

a_{1}\end{array}\right]\end{displaymath}](img420.png)

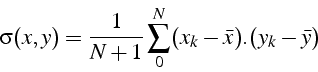

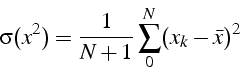

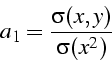

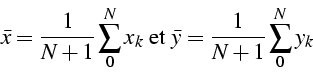

en introduisant la moyenne des ![]() et

et ![]()

la covariance et la variance