(et ce qui a été ajouté en utilisant la technique)

#ifdef FRAGMENT_SHADER

uniform sampler2D zbuffer;

out vec4 fragment_color;

void main( )

{

float z= texelFetch(zbuffer,

ivec2(gl_FragCoord.xy), 0).r; // !! texture() et texelFetch()

renvoient un vec4(z, 0, 0, 0) !!

z= pow(z, 256);

// la valeur de Z n'est pas lineaire dans le

repere image...

fragment_color= vec4(z, z, z, 1);

}

#endif

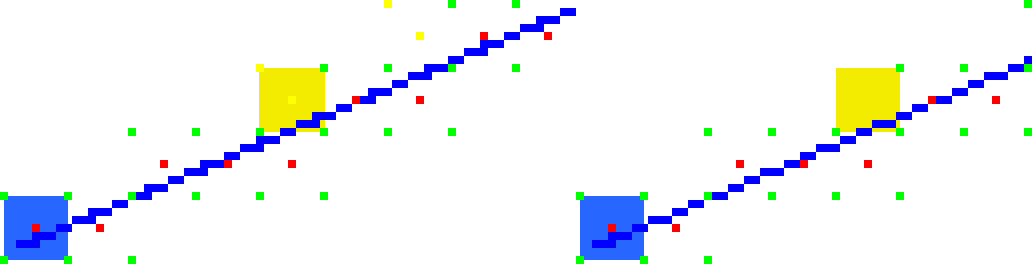

d'autres solutions adaptées aux gpu sont publiées, par exemple : "Efficient GPU Screen-Space Ray Tracing", M. McGuire, M. Mara, 2014vec3 a= vec3( ... );

vec3 b= vec3( ... );

vec3 d= { ... };

int n= { ... };

vev4 color= vec4( ... );for(int i= 0; i < n; i++)

{

vec3 p= a + i * d; // p(i)

vec3 pm= a + (i + 0.5) * d; // p(i+.5), point intermédiaire / midpoint

pixel(floor(p.x), floor(p.y))= color;

pixel(floor(pm.x), floor(pm.y))= color;

}